„Ich will … darauf aufmerksam machen, dass Meinungsbildung heute grundsätzlich anders verläuft, als das vor 25 Jahren der Fall war. Dass heute Fake-Seiten, Bots, Trolle Meinungsbilder verfälschen können. Dass heute sich selbst regenerierende Meinungsverstärkungen durch bestimmte Algorithmen stattfinden. Und wir müssen lernen, uns damit auseinanderzusetzen.“ (Angela Merkel)

Während der Haushaltsdebatte 2016 äußerte Kanzlerin Angela Merkel ihre Sorge um die Zukunft der politischen Meinungsbildung in Zeiten der Fake News und Filterblasen. Damit griff sie die Debatte um Informationsblasen im Netz auf, der die Wahl von Donald Trump zum nächsten US-Präsidenten zu neuer Aufmerksamkeit verholfen hat. Ein „Fake“ war zum Beispiel der Facebook Post, der in den letzten drei Monaten vor der Wahl am meisten geteilt, ‚geliket‘ und kommentiert wurde – die angebliche Unterstützung Trumps durch Papst Franziskus. Genauso gefälscht waren weitere vier der zehn erfolgreichsten Facebook-Posts aus dieser Zeit. Ebenso wurden sowohl auf Seiten Trumps als auch für Hillary Clinton „Bots“, das heißt computergesteuerte Social-Media-Profile im Wahlkampf eingesetzt. Über diese Bots wurden dann zum Beispiel auf Twitter Nachrichten und bestimmte Meinungen weiterverbreitet.

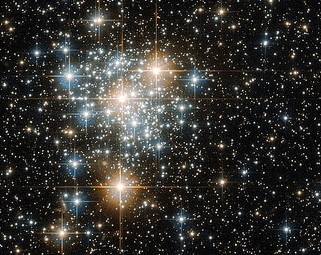

Bild: NASA Goddard Space Flight Centre ‚Hubble Serves Up a Holiday Snow Angel’/ flickr.com (CC BY 2.0)

Wie Netzpolitik.org als Reaktion auf Angela Merkels Rede anmerkt, gehen in der aktuellen Debatte viele Begriffe durcheinander: Bots, Fakes, Trolle, Hate Speech, Filter. Sie alle sind Teil einer neuen Meinungslandschaft, die derzeit Politik und Gesellschaft verändert. Was diese technischen Mittel und Entwicklungen eint, ist ihr Resultat: Alle erzeugen unterschiedliche Formen von Informationsblasen.

Ein Thema, eine Meinung oder eine falsche Nachricht werden durch Meinungs-Bots sowie durch menschliche User künstlich so lange aufgeblasen, bis sie sich ins Aufmerksamkeitsfeld der Öffentlichkeit schieben, zum Beispiel als „Trending Topic“ bei Twitter oder Facebook. Menschen, die Hassreden (Hate Speech) verbreiten sowie „Trolle“, die über Social Media Provokationen und Unsinn publizieren, um eine sinnvolle Debatte zu verhindern, erschaffen eine Blase, in der Hass, Diskriminierung und Lüge plötzlich legitime Kommunikationsformen zu sein scheinen. Algorithmen sowie die Internet-Nutzer(innen) selbst schaffen sich schließlich Informationsblasen, in denen ihnen nur nach ihren Interessen ausgewählte Informationen und homogene Sichtweisen ohne Widerspruch begegnen.

Ebenso ist anzumerken: Deutschland ist nicht die USA. Kein Kandidat vom Kaliber Trumps bespielt hier die mediale und politische Bühne. Auch die Mediensysteme und das Verhalten von Medienkonsument(inn)en unterscheiden sich. Zum Beispiel sind Länder mit einem starken öffentlich-rechtlichen Rundfunk für rechtsextreme Tendenzen weniger anfällig. Auch spielt Twitter in Deutschland eine geringere Rolle als in den USA: Hierzulande nutzen nur vier Prozent der über 14-Jährigen mindestens einmal pro Woche Twitter. In den USA nutzt jeder fünfte Erwachsene den Kurznachrichtendienst, davon mehr als die Hälfte mindestens einmal pro Woche. Der Service der Trending Topics auf Facebook, über den in den Vereinigten Staaten auch Fake News als besonders beliebte Facebook-Beiträge angezeigt werden, ist in Deutschland bisher nicht verfügbar.

Nichtsdestotrotz gibt es auch in Deutschland Entwicklungen, die Informationsblasen fördern: Das Vertrauen in die Medien – gerade in die öffentlich-rechtlichen Sender – schwindet, nicht zuletzt befeuert von „alternativen“ Informationsangeboten, die nur eine bestimmte Sicht auf die Welt präsentieren. Debatten um den Ukraine-Konflikt und die „Flüchtlingskrise“ wurden bereits von den verschiedenen Dimensionen der Informationsblasen beeinflusst. Wenn 2017 auch in Deutschland gewählt wird, ist auch hier ein Einfluss von Fakes und „Social Bots“ auf die Meinungsbildung zu erwarten.

Daher lohnt ein genauerer Blick auf die Phänomene, die in ihrem Zusammenspiel Informationsblasen erzeugen. Ein Vergleich zwischen Beispielen aus den USA und Deutschland zeigt, dass sich hier Ähnliches beobachten lässt, auch wenn sich die Tragweite jeweils unterscheidet. Eine Betrachtung der Hintergründe, die das Entstehen von Informationsblasen fördern, ermöglicht auch Perspektiven auf Wege aus der Informationsblase.

Die Phänomene

Social Bots

„Social Bots sind von Menschen programmierte Software-Roboter. Sie sammeln Informationen und Daten, setzen aber auch bewusst Trends und Topthemen in den sozialen Medien, ohne dass der Nutzer davon Kenntnis hat.“ (Simon Hegelich, Professor für Political Data Science, TU München)

Emilio Ferrara, Assistenzprofessor an der University of Southern California, und Alessandro Bessi, Doktorand an der Universität Pavia, schätzen, dass im von ihnen untersuchten Zeitraum zwischen Mitte September und Mitte Oktober 2016 einer von fünf Tweets zur US-Wahl durch einen von 400.000 Social Bots abgesendet wurde. Bots wurden dabei auf beiden politischen Seiten eingesetzt, wobei für Trump dreimal so viele Bots aktiv waren wie für Clinton.

Eine nichtrepräsentative Umfrage von YouGov in Deutschland ergab, dass 48 Prozent der Befragten noch nie vom Begriff „Social Bots“ gehört haben und nur die Hälfte derer, die ihn kennen, weiß, was dieser bedeutet.

Während die USA ihre Wahl gerade hinter sich haben, steht sie in Deutschland im kommenden Jahr an. Auch hier ist zu vermuten, dass Bots eine Rolle im Wahlkampf spielen werden. Die Parteien im Bundestag und die FDP lehnen den Einsatz von Bots ab. Alice Weidel, Mitglied des Bundesvorstands der Alternative für Deutschland (AfD), hingegen kündigte gegenüber dem Spiegel am 21. Oktober 2016 an: „Selbstverständlich werden wir Social Bots in unsere Strategie im Bundestagswahlkampf einbeziehen.“ Zwei Tage später distanzierte sich die Politikerin wieder von dieser Aussage, wie auf der Website der Partei berichtet wird.

Forscher am University College London haben kürzlich ein Botnetz aus 35.000 Accounts entdeckt. Es twitterte aber nicht zu Politik sondern Zitate aus Star Wars. Damit können die Tweets nicht gleich als maschinengeneriert identifiziert werden. Seit Juli 2013 kam kein Tweet mehr aus diesem Netzwerk, aber die Konten existieren weiter. Die Experten gehen davon aus, dass die Bot-Accounts bereits als „falsche“ Follower vermarktet werden. Genauso denkbar ist auch, dass das gesamte Bot-Netz verkauft werden kann und dann wieder mit Tweets aktiv wird, die die Sache des Käufers unterstützen.

Das Online-Magazin Vice-Motherboard zeigt in einer Analyse der Anhängerschaft deutscher Politiker(innen) auf Twitter, dass schon heute bis zu 60 Prozent ihrer neuesten Follower auf Twitter Bots sind. Wer diese ins Netz geschickt und bezahlt hat, ist dabei nicht nachzuvollziehen. Auch hier besteht die Möglichkeit, dass die Bots auf einen anderen Einsatz – zum Beispiel während des Bundestagswahlkampfs warten. Wie viel, wann und was Social Bots schon heute zur deutschen Politik twittern behält Botswatch, ein Team aus Datenanalysten und Webentwicklern im Auge. Ihre Analyse zum Fernsehtalk „Hart aber Fair“ zum Thema „Schockjahr 2016“ zeigt, dass während der Sendung 132 Bots auf Twitter zum Hashtag #hartaberfair aktiv waren. Obwohl sie damit ’nur‘ 12 Prozent der aktiven Twitter User zu diesem Thema stellten, trugen sie 21 Prozent der Tweets bei.

Tipps wie man Social Bots im Netz entlarvt gibt zum Beispiel Spiegel Online: Indizien für Bot-Aktivitäten sind zum Beispiel viele Tweets zu nur einem Thema, die in einer ‚unmenschlichen‘ Frequenz gesendet werden. Auch sollte überprüft werden, wie lange ein Account schon aktiv ist und wie gut ‚gepflegt‘ die Angaben in der Beschreibung sind.

Fake News

„Wir sollten von Fake News reden, wenn Falschinformationen absichtlich gestreut werden – und dabei so komponiert werden, dass sie Funktionslogiken sozialer Netzwerke ausnutzen: Weil sie sich viral verbreiten sollen, setzen sie auf Reflexe wie Empörung und gefühlte Wahrheit und auf Reizthemen wie Migranten und Flüchtlinge, Kinder und Missbrauch, Krieg und Frieden.“ (Fabian Reinbold, Journalist)

In Deutschland führt gerade das Thema „Flüchtlinge“ zur Verbreitung von Unwahrheiten: Die für den Grimme Online Award 2016 nominierte Hoaxmap hat seit Februar 2016 bereits über 430 Fake News über Flüchtlinge im deutschsprachigen Raum gesammelt und widerlegt, die sich aber zuvor bereits in den sozialen Netzwerken verbreitet hatten. Der freie Journalist Martin Fischer weißt in seiner Analyse von 50 Artikeln aus der Hoaxmap darauf hin, dass es dabei eine Reihe verschiedener Arten von Unwahrheiten gibt.

Dass dies nicht immer nur mit politisch motiviertem Hintergrund geschieht zeigt die Geschichte der Pistenraupe, die von einem angeblich unbedarften LKW-Fahrer nach Seefeld in Schleswig-Holstein anstatt in das gleichnamige Skigebiet in Österreich geliefert wurde. Diese Story wurde von vielen Medien aufgegriffen, war aber nichts anderes als ein gut inszenierter PR-Coup. Der Deutsche Rat für Public Relations (DRPR) sprach in dem Fall eine Rüge gegen die Beiteiligten aus.

Der „Fake“, das heißt die Fälschung kann sich in verschiedenen Formen in die „News“, das heißt in die Nachricht(en) einschleichen. Dokumente können bewusst gefälscht werden, wie Statusmeldungen bei Facebook, etwa indem Titel und Bilder ausgetauscht werden. Ein Beispiel hierfür ist ein auf Facebook verbreitetes angebliches Zitat von Renate Künast. Falschaussagen können bewusst in den Umlauf gebracht werden mit dem Ziel in sozialen Netzwerken und in seriösen Medien zu erscheinen. Eine dritte Kategorie von Fake News – im engeren Sinne – sind Meldungen in Medienangeboten, die wie ihre seriösen Vorbilder als Nachrichtenseiten im Netz erscheinen, dabei aber Geschichten verbreiten, die nicht der Wahrheit entsprechen. Wie diese Strategie der Imitation von Nachrichten gegen Flüchtlinge eingesetzt wird analysiert Netz gegen Nazis ausführlich. Ein aktuelles Beispiel ist die angeblich von Flüchtlingen in Brand gesteckte Kirche, von der die US-amerikanische Seite Breitbart berichtete. Die Seite ist Sprachrohr der Alt-Right-Bewegung in den USA; ihr Gründer Steve Bannon hat Donald Trump bereits im Wahlkampf unterstützt und ist nun sein Chefstratege im Weißen Haus und Mitglied des nationalen Sicherheitsrates.

Dass solche Falschnachrichten auch reale Konsequenzen haben, zeigte das Beispiel #pizzagate. Ein junger bewaffneter Amerikaner stürmte Anfang Dezember eine Pizzeria in Washington, schoss und bedrohte Angestellte. Der Grund: Er wollte auf eigene Faust gegen den Kinderporno-Ring ermitteln, den Hillary Clinton und ihr Team aus dieser Pizzeria heraus betrieben. Diesen Fake verbreitete unter anderem Ex-General Michael Flynn, der mittlerweile Sicherheitsberater von Donald Trump ist.

Tipps, wie man Fake News erkennt, gibt mimikama.at Empfohlen wird zum Beispiel über die umgekehrte Bildersuche von Google den Ursprung von Bildern in verdächtigen Nachrichten zu überprüfen.

Hate Speech

„Unter Hate Speech wird im Allgemeinen der sprachliche Ausdruck von Hass gegen Personen oder Gruppen verstanden, insbesondere durch die Verwendung von Ausdrücken, die der Herabsetzung und Verunglimpfung von Bevölkerungsgruppen dienen.“ (Jörg Meibauer, Professor für Sprachwissenschaft des Deutschen an der Universität Mainz)

Während derzeit die Einflussnahme von Social Bots und Fake News auf die öffentliche Meinung in Nachrichten und Politik diskutiert wird, war es vor gut einem Jahr das Thema „Hate Speech“, das die Debatten um die Netzkultur dominierte. Im Herbst 2015 wurde daraufhin auf Initiative des deutschen Justizministers eine Task Force gegen strafrechtlich relevante Hetze im Netz gegründet. Etwa ein Jahr später gab Facebook bekannt, 100.000 Kommentare in Deutschland von der Plattform gelöscht zu haben.

Bild: martingreffe ‚Hate‘ / flickr.com (CC BY 2.0) Mehr zum Thema „Hate Speech“ im Kontext Hass und Hetze im Internet

Das Problem der herabwürdigenden oder gar volksverhetzenden Kommentare im Internet ist damit allerdings nicht erledigt; im Gegenteil, Hassrede ist ein integraler Bestandteil der extremen Informationsblasen im Netz. Fake News, aber auch korrekte Berichterstattung zu Flüchtlingen, die in rechten Kreisen zirkulieren, ziehen viele Hasskommentare nach sich. Auch Social Bots können eingesetzt werden, um zum Beispiel auf Twitter standardmäßig mit Hassbotschaften auf bestimmte Themen zu reagieren. Beiträge, die oft kommentiert werden, erscheinen wiederum prominenter in den sozialen Netzwerken. Durch die Abschottung der unterschiedlichen Informationsblasen voneinander bleibt der Hass ohne Gegenrede.

„Als Troll bezeichnet man eine echte Person, die in der Netzkommunikation durch Provokation, Störung, Beleidigungen und schiere Häufigkeit der Kommunikation auffällt.“ (Netzpolitik.org)

Allein schon die Masse an Hasskommentaren oder Unsachlichkeiten beeinflusst das Klima von Online-Diskussionen, bis eine sinnvolle Debatte nicht mehr möglich ist. Ein weiteres Ziel von Hate Speech und Störverhalten von Trollen im Netz ist es, dafür zu sorgen, dass sich die persönlich angefeindeten Personen aus der Diskussion zurückziehen. So gab zum Beispiel der SPD-Lokalpolitiker Thomas Purwin seinen Rücktritt vom Amt des Parteivorsitzenden der SPD in Bocholt bekannt, nachdem er per E-Mail und Social Media Anfeindungen und Drohungen gegen seine Familie erhalten hatte.

Filterblasen

Wie der Vergleich eines liberalen und eines konservativen Facebook Feeds, zeigt, können sich Anhänger beider Lager in homogenen Filterblasen einrichten, in denen ihnen immer wieder eine bestimmte Sicht auf ein Thema gespiegelt wird. Der öffentlich-rechtliche online-Sender funk hat die gefilterten Social Media Feeds auch für Deutschland veranschaulicht.

Als der Interntaktivist Eli Pariser 2011 mit seinem Buch Filter Bubble: Wie wir im Internet entmündigt werden das Phänomen der Personalisierung von Informationsströmen zum ersten Mal ausführlich und für ein breites Publikum beschrieb, stützten sich seine Beobachtungen auf einzelne Beispiele und persönliche Erfahrungen. Pariser, der sich selbst als liberal einstuft, erkannte zum Beispiel, dass ihm mit der Zeit Links, die seine konservativen Facebook-Freunde geteilt haben, seltener angezeigt wurden als die seiner liberalen Kontakte.

In einer 2015 veröffentlichten Studie haben Forscher(innen) über 10 Millionen Datensätze von Facebook-Nutzer(inne)n genau auf diese Frage hin ausgewertet und kamen zu dem Schluss: Die Auswirkungen des Facebook-Filter-Algorithmus auf die Auswahl der angezeigten Nachrichten ist gering: „Konservative sehen etwa fünf Prozent weniger Inhalte aus dem anderen politischen Lager im Vergleich zu dem, was ihre Freunde tatsächlich teilen, während Liberale etwa acht Prozent weniger ideologisch anders gefärbte Inhalte sehen“, werden die Autoren bei Spiegel Online zitiert. Die doppelte Krux dieser Untersuchung: Die Wissenschaftler arbeiten bei Facebook; gleichzeitig sind sie die Einzigen mit dem für solche Recherchen notwendigen Zugriff auf Nutzerdaten. Die Auswirkung der Filtermechanismen lässt sich also kaum unabhängig bestimmen.

Bild: NASA Goddard Space Flight Centre, Hubble Takes Flight with the Toucan and the Cluster / flickr.com (CC BY 2.0)

Auch in Deutschland richten sich Internetnutzer(innen) in Meinungsblasen ein, verstärkt durch falsche Freunde und Nachrichten. Wie eine Analyse des Facebook-Umfelds der Anhänger(innen) von Pegida Nürnberg zeigt, spielen für sie etablierte Medien kaum eine Rolle, während ihr Nachrichten-Stream innerhalb des Online-Netzwerks von Informationen der AfD, von anderen Pegida-Ablegern und „alternativen“ Nachrichtenmedien wie Compact oder Russia Today dominiert wird. So bilden sich gegensätzliche Informationsblasen im Netz: Nach dem Amoklauf im Münchener Olympia-Einkaufszentrum im Juli 2016 wertete der Journalist und Journalismus-Forscher Gerret von Nordheim 80.000 Tweets zum Geschehen aus und stellte fest: Einerseits bildete sich eine Sphäre, in der Informationen der Polizei und der traditionellen Medien geteilt wurden; auf der anderen Seite eine Sphäre aus Medien und Vertretern des rechten Spektrums, in der schnell Angela Merkels Flüchtlingspolitik für den Anschlag verantwortlich gemacht wurde. Verbindungen zwischen beiden Lagern gab es so gut wie nicht.

Die (Hinter-)Gründe

Für die weltweite Zunahme von Fake News und extremen Meinungen allein nicht-journalistische Medien und Facebook verantwortlich zu machen, greift allerdings zu kurz. Welche Nachrichten User im Internet im Allgemeinen und auf Facebook und Google im Speziellen präsentiert bekommen, hängt zu großen Teilen von ihnen selbst ab. Die Funktionsweise, die Dynamiken und die Ziele vor allem von sozialen Online-Netzwerken können aber dafür sorgen, dass sich Menschen nicht unbedingt nur aus rationalen Stücken für das Lesen oder Weiterverbreiten bestimmter Nachrichten entscheiden.

Menschliche Entscheidungen

Der Fokus auf die Filter-Algorithmen lenkt von der Tatsache ab, dass die Entscheidungen, die die Nutzer(innen) selbst treffen, den größten Einfluss auf ihre Informationsblase haben: Welche Informationsquellen werden abonniert? Wer sind die Freunde, mit denen man auf Facebook verbunden ist, und vor allem: Welche Links und Quellen klickt und „liket“ man? In dieser Hinsicht sind Filterblasen selbstgewählte Umgebungen; ähnlich der Entscheidung, welche Tageszeitung man abonniert und mit wem man am Stammtisch diskutiert. Menschen umgeben sich schon immer gerne mit Meinungen, die den ihren entsprechen.

Durch die vielen Personalisierungsmöglichkeiten sowie die medialen Nischenangebote im Netz ist es viel einfacher geworden, sich seine eine Informationsblase zusammenzustellen. Filter- und Vorschlagsalgorithmen helfen dabei zusätzlich und das nicht immer offensichtlich. So stellt sich die Frage, wie informiert die Wahl der eigenen Informationsblase geschieht.

martialred / fotolia.com Mehr zum Thema „Lügenpresse“ im Kontext Vertrauenskrise der Medien

Auch wählen Menschen zweifelhafte Informationsquellen ja gerade deshalb, weil sie ihnen glaubwürdiger erscheinen als „Mainstream“-Medien und „Lügenpresse“. Dabei ist die Wahl des Informationsmediums aber nicht immer eine ideologische: In einer Studie der Stanford University hielten Highschool-Schüler(innen) einen PR-Beitrag eines Ölkonzerns zum Thema Klimawandel für glaubwürdiger als den Artikel eines Wissenschaftsjournalisten. Der PR-Beitrag überzeugte sie schlicht durch mehr Grafiken und Tabellen. Genauso wenig scheint es amerikanischen Twitter-Nutzer(inne)n im Wahlkampf aufgefallen oder wichtig gewesen zu sein, dass nicht alle ihre Online-Kontakte Menschen sind, denn sie verbreiteten Nachrichten von Bots genauso häufig wie die von Menschen.

Emotionen & Unmittelbarkeit

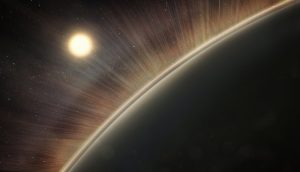

Bild: NASA’s Marshall Space Flight Center,

‘Electric Wind’ Can Strip Earth-like Planets of Oceans, Atmospheres / Flickr.com (CC BY-NC 2.0)

Welche Stimmung eine Nachricht hervorruft, ist etwa über „Emojis“, mit denen man auf Nachrichten reagieren kann, sofort sichtbar. Im Gegensatz zu Nachrichten in klassischen Medien sind News auf Facebook also emotional gerahmt. Was auf den sozialen Plattformen zählt, ist das, was geteilt, geliket und weiterverbreitet wird. Richtigstellungen haben keine Chance, ähnlich weit verbreitet zu werden. Die Nachricht Papst Franziskus unterstütze Trump wurde auf Facebook insgesamt knapp eine Million Mal geteilt, mit „gefällt mir“ markiert oder kommentiert. Die Enttarnung des Fakes durch das Portal Snopes.com wurde hingegen nur knapp 70.000 Mal auf Facebook geteilt.

Journalisten verstärken „gefühlte Wahrheiten“ unter Umständen sogar, wenn sie den Online-Trends ungeprüft Raum in ihrer Berichterstattung geben. Netzpolitik.org warnt daher:

„Journalisten müssen bei der populär gewordenen Form der „Das sagt das Netz“-Berichterstattung besser aufpassen. Aussagen wie „Anhänger von XY ließen den Hashtag #XYgewinnt über 18 Stunden trenden“ sind nichts wert, wenn man nicht weiß, ob es sich um echte Anhänger oder Bots handelt.“ (Netzpolitik.org)

Die Schnelligkeit der Informationsverbreitung zeichnet dabei nicht nur die Plattformen selbst aus, sondern beeinflusst auch die Erwartung der Nutzer(innen). So zeigte eine Studie des JFF Instituts für Medienpädagogik und der Universität Leipzig, dass vor allem jüngeren Jugendlichen die Aktualität von Informationen wichtiger ist als die Fragen, ob diese überprüft sind oder aus einer offiziellen Quelle stammen.

Geld

Die Möglichkeit, Fake News in die Welt zu setzen und bestimmte Meinungen künstlich zu verstärken, haben nicht mehr nur größere Institutionen, sondern auch Individuen. Es lassen sich täuschend echte Nachrichten durch wenige Klicks bei Facebook selbst erzeugen, etwa indem man Titel und Bilder geteilter Links austauscht. Social Bots und Aktivitäten von Fake Accounts lassen sich für viel weniger Geld kaufen als eine PR-Abteilung kosten würde: 1.000 Twitter Accounts gibt es ab 45 US-Dollar, die passende Software zu deren Steuerung kostet $ 500. Eine Recherche von ZDFzoom bei einem deutschen Anbieter hat ergeben: Facebook Likes gibt es für 12 Cent pro Stück und für knapp 40 Euro kann man über 200 Facebook-Kommentare echter User kaufen.

„Facebooks Geschäft ist es, Werbeplätze zu verkaufen. Deshalb profitiert es von jedem viralen Inhalt, egal, ob er wahr oder frei erfunden ist.“ (Patrick Beuth, Journalist)

Das höhere Ziel der Fake News ist nicht immer (nur) politische Stimmungsmache, denn mit Fake News lässt sich auch Geld verdienen. Fake News mit ihrem oft unglaublichen Inhalt und ihrer reißerischen Präsentation fungieren dabei wie „Clickbait“, das heißt wie Köder für Leser(innen), die der veröffentlichenden Seite durch ihre Klicks Werbeeinnahmen bescheren. In ihrem angekündigten Kampf gegen Fake News zielen Google und Facebook daher darauf ab, den verbreitenden Seiten die Werbeeinnahmen zu entziehen. Dies verdeutlicht aber auch im Umkehrschluss, dass Google und Facebook als größte Werbevermittler im Netz ebenfalls von Fake News profitieren.

Dadurch, dass Online-Werbung nicht direkt von den Seiten vermarketet wird, die die Werbeflächen anzeigen, sondern über Agenturen, ist für werbende Firmen nicht immer klar, wo ihre Werbung zu sehen sein wird und wen sie mit ihrem Werbebudget damit indirekt unterstützen. 700 Unternehmen weltweit haben bereits verhindert, dass Werbung für ihre Produkte auf der US-Amerikanischen Seite Breitbart zu sehen ist.

Selbstverständnis und Politik der Plattformen

Nicht nur aufgrund der finanziellen Interessen von Facebook sind Zweifel an der Wirksamkeit aktuell angekündigter Maßnahmen gegen Fakes und Hass im Netz angebracht. Dies liegt am Selbstverständnis der Plattform: Facebook lehnt regelmäßig die Verantwortung für die Inhalte auf ihrer Website ab, da es sich als bloße Infrastruktur versteht. Facebook definiert sich selbst nicht als ein journalistisches Medium und wehrt sich damit gegen Regulierungsinitiativen.

Gerade bei audiovisuellem Material müssen immer noch Menschen über die Löschung entscheiden – eine zermürbende Arbeit hinter verschlossenen Türen, die Facebook an Dienstleister in Deutschland und der ganzen Welt outsourcet.

Anstatt von Redakteuren übernehmen Algorithmen die Sortierung von Nachrichten in den Trending Topics auf Facebook. Tauchen Fakes, Hass und Gewalt auf der Plattform auf, sind derzeit ebenfalls Algorithmen sowie die User selbst gefragt. Sie sollen unerwünschte Inhalte melden. Dieses Meldesystem wird als intransparent und langsam kritisiert.

Im Fall von Hate-Speech oder Gewaltdarstellungen gehen die Meldungen in Deutschland beim Dienstleister Avarto ein. Falls nicht wie bei strafrechtlich relevanten Kommentaren von der Politik eingefordert, sind die vage formulierten Gemeinschaftsstandards die Entscheidungsgrundlage für das Löschen von Inhalten auf Facebook. Dazu kommen weitere unveröffentlichte Regeln, die bestimmen, was auf der Plattform sein darf. Wie sich an Facebooks rigoroser Löschpolitik von Nacktbildern zeigt, setzt das Unternehmen hier ein eigenes Moralverstehen durch. Dem fällt mitunter auch Satire zum Opfer, wie im Fall des Titanic-Chefredakteurs Tim Wolff. Er hatte Zeitungsseiten mit Abbildungen (halb-)nackter Frauen in der BILD abfotografiert und auf Facebook veröffentlicht, um auf Sexismus aufmerksam zu machen. Für diesen Verstoß gegen die Gemeinschaftsstandards wurde er für einen Tag von Facebook gesperrt.

Statt auf Löschen, möchte Facebook bei Hate Speech hingegen lieber auf Gegenrede (Counterspeech) setzen. Diese Strategie ist nicht nur umstritten, sie wälzt auch wieder Verantwortung auf die Nutzer(innen) ab und sorgt, so sich genügend Menschen darauf einlassen, für mehr Betrieb und damit auch mehr Werbeeinnahmen auf Facebook.

Auch für Fake-News soll es bald ein Meldesystem gehen. Gemeldete Fälle von Nachrichten, die sich besonders stark weiter verbreiten, sollen an unabhängige Fakt-Prüfer weiter geleitet werden, die dann bewerten ob es sich um Fake-News handelt. Für den deutschsprachigen Raum ist Facebook dafür mit dem Recherchebüro „Correctiv“ aus Essen und Berlin im Gespräch. Anders als im Fall von Inhalten, die gegen die Community Standards verstoßen ist geplant, als Fake-News identifizierte Beiträge nicht zu löschen. Vielmehr sollen sie mit einem Hinweis versehen werden, der die Einschätzung der Experten darstellt sowie zu Fakten führt, welche die ursprüngliche Nachricht in Frage stellen. Wie die Zusammenarbeit mit den Fakt-Checkern genau aussehen soll, wie sie unabhängig finanziert werden kann und nach welchen Kriterien die Prüfungen verlaufen sollen, ist aber noch unklar. Schon jetzt sieht sich das Correctiv-Team Angriffen gegen ihre Recherchearbeit ausgesetzt. Sollten sie tatsächlich in Zukunft auf Facebook gegen Fake News vorgehen, besteht die Gefahr, dass auch diese von bestimmten Interessensgruppen über das Maß berechtigter Kritik hinaus gestört wird.

Wege aus der Blase

Bild: César.Gutiérrez / flickr.com (CC BY-NC-ND 2.0)

Seinen Artikel Der Mythos von der Filterblase schließt Christoph Behrens in der Süddeutschen Zeitung mit der Bemerkung: „Die allererste Filterblase ist der menschliche Verstand.“ Jeder Mensch nimmt aufgrund seiner individuellen Umstände die Welt anders wahr und sucht sich diejenigen Medien oder Menschen, die eine solche Wahrnehmung unterstützen. Gleichzeitig ist der menschliche Verstand aber auch die einzige Möglichkeit, aus der Filterblase heraus zu finden. Wer alleine mit Algorithmen und bestellten Dienstleistern gegen Fakes vorgehen will, riskiert nicht nur Satire auszusortieren, sondern gibt die Definition von Wahrheit und gutem Umgang miteinander in die Hände von Konzernen mit ihren jeweiligen Eigeninteressen.

Wer kann etwas gegen Fake News tun und wie kann das geschehen? Curd Knüpfer, Politologe am JFK Institut der FU Berlin, gibt Tipps, zum Beispiel eine „ausgewogene Mediendiät“.

Am Ende braucht es menschliche Vernunft, Zeit für Recherche und eine unabhängige Beurteilung, um Fakt von Fake zu trennen und Nachrichten korrekt einzuordnen, sowohl auf der Seite der Journalist(inn)en als auch bei den Nutzer(inne)n. Auch Facebook scheint dies erkannt zu haben und kündigte am 16. Dezember 2016 an, in Zukunft mit der Nachrichtenagentur Associated Press und Rechercheportalen wie Snopes.com zusammen arbeiten zu wollen, um Fakes zu enttarnen.

Die Wahrheit kann weder zwischen Fakt und Fake noch im „Gefühl“ liegen, sondern nur zwischen verschiedenen Perspektiven, die sich auf belastbare Informationen stützen. Durch Aufklärung über Fakes, Bots und Filtermechanismen können sowohl Medien als auch Bildungseinrichtungen Internetnutzer(innen) in ihrem Umgang mit Informationsblasen unterstützen sowie Brücken zwischen den unterschiedlichen Sphären bauen. Manche Hass- und Lügenblasen werden dennoch bestehen bleiben. Hier stellt sich für Medien und Zivilgesellschaft die Frage, welcher Raum ihnen im öffentlichen Diskurs gegeben werden soll, um sie nicht noch weiter zu verbreiten und zu verstärken.

Veröffentlicht: Dezember 2016

Zuletzt aktualisiert: Januar 2017